Thank you for reading this post, don't forget to subscribe!

имеется ceph кластер

ceph1-131 192.168.1.131

ceph2-132 192.168.1.132

ceph3-133 192.168.1.133

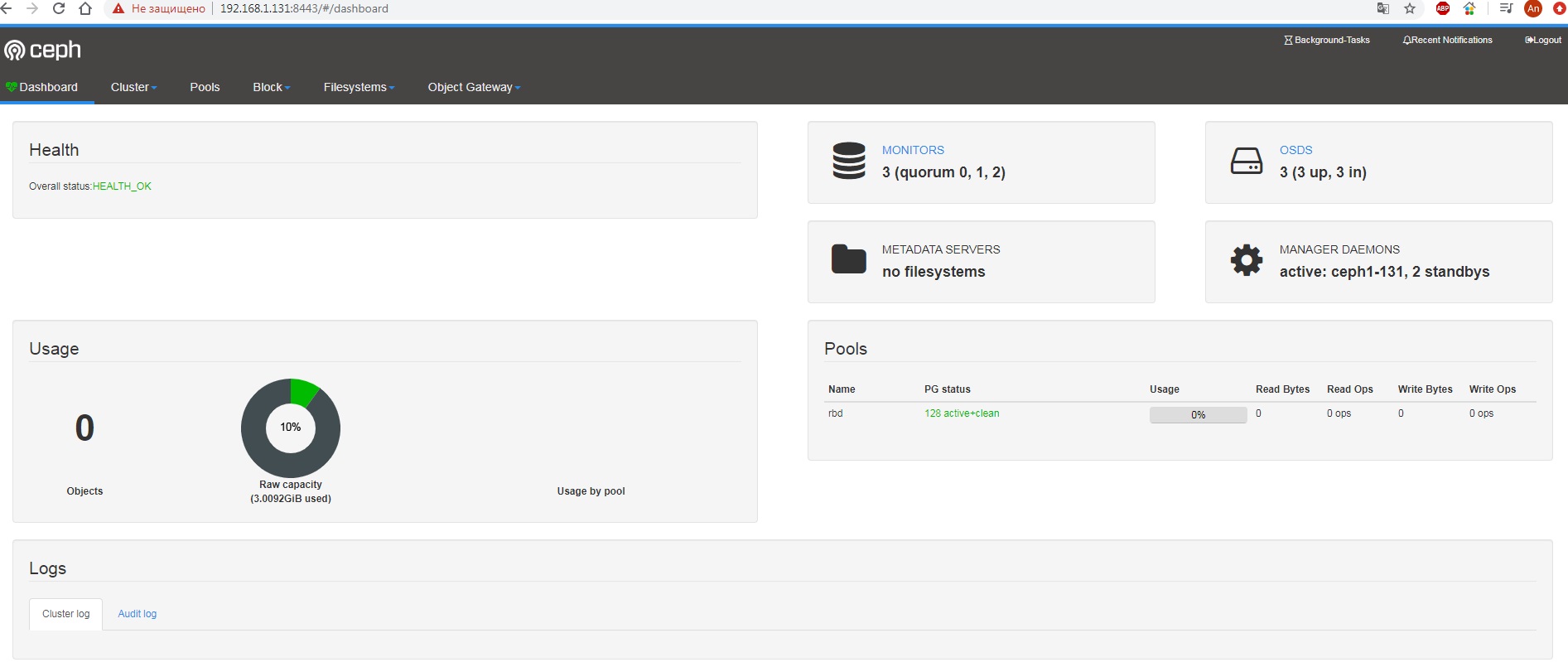

проверяем что статус ОК:

[root@ceph1-131 ~]# ceph -s

cluster:

id: 3bacf392-bbeb-4b1f-a07c-0060342c8d74

health: HEALTH_OK

services:

mon: 3 daemons, quorum ceph1-131,ceph2-132,ceph3-133

mgr: ceph1-131(active), standbys: ceph3-133, ceph2-132

osd: 3 osds: 3 up, 3 in

data:

pools: 1 pools, 128 pgs

objects: 0 objects, 0 B

usage: 3.0 GiB used, 27 GiB / 30 GiB avail

pgs: 128 active+clean

[root@ceph1-131 ~]# ceph osd tree

ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 0.02939 root default

-3 0.00980 host ceph1-131

0 hdd 0.00980 osd.0 up 1.00000 1.00000

-5 0.00980 host ceph2-132

1 hdd 0.00980 osd.1 up 1.00000 1.00000

-7 0.00980 host ceph3-133

2 hdd 0.00980 osd.2 up 1.00000 1.00000

|

1 2 3 4 5 6 7 8 |

[root@ceph1-131 ~]# ceph osd status +----+-----------+-------+-------+--------+---------+--------+---------+-----------+ | id | host | used | avail | wr ops | wr data | rd ops | rd data | state | +----+-----------+-------+-------+--------+---------+--------+---------+-----------+ | 0 | ceph1-131 | 1027M | 9204M | 0 | 0 | 0 | 0 | exists,up | | 1 | ceph2-132 | 1027M | 9204M | 0 | 0 | 0 | 0 | exists,up | | 2 | ceph3-133 | 1027M | 9204M | 0 | 0 | 0 | 0 | exists,up | +----+-----------+-------+-------+--------+---------+--------+---------+-----------+ |

активируем необходимый модуль:

Данные команды лучше всего запускать из под пользователя с которого деплоился ceph т.е. с пользователя ceph из директории /vat/ceph-adminDIR

[root@ceph1-131 ~]# ceph mgr module enable dashboard

проверяем:

[root@ceph1-131 ~]# ceph mgr module ls

{

"enabled_modules": [

"balancer",

"crash",

"dashboard",

"iostat",

"restful",

"status"

],

создаём самоподписанный сертификат:

[root@ceph1-131 ~]# ceph dashboard create-self-signed-cert

Self-signed certificate created

для ceph установленного из mimic репозитория, создаём пользователя admin пароль admin

[root@ceph1-131 ~]# ceph dashboard set-login-credentials admin admin

Username and password updated

смотрим по какому урлу нам заходить:

[root@ceph1-131 ~]# ceph mgr services

{

"dashboard": "https://ceph1-131:8443/"

}

можем зайти и так:

https://192.168.1.131:8443/#/login

тут можно создавать rbd снапшоты а также следить за состоянием кластера